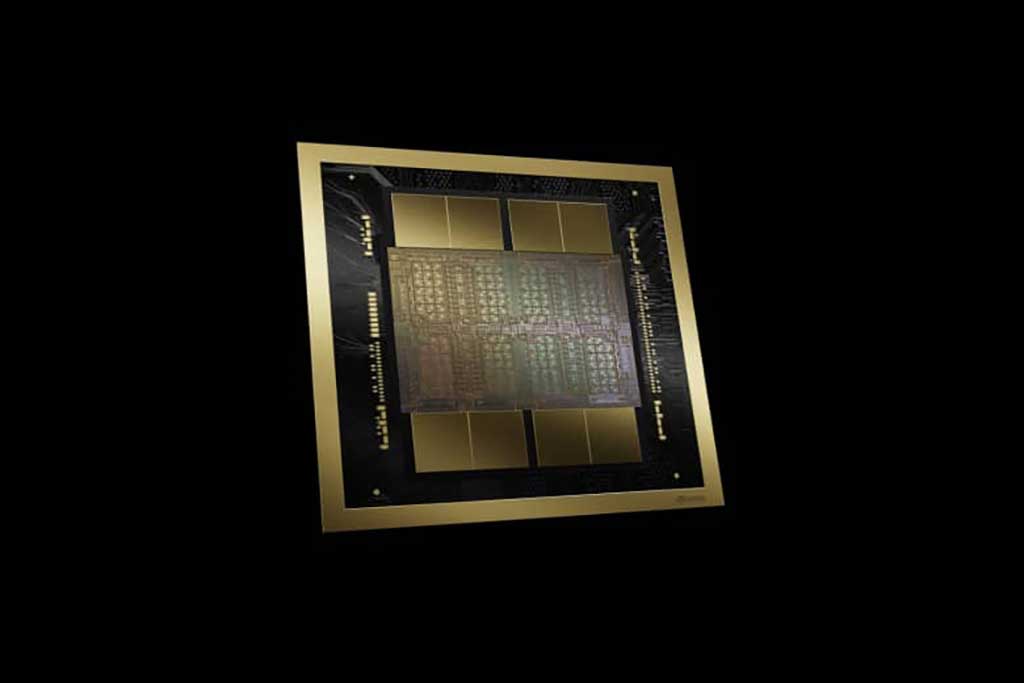

在 NVIDIA GTC 2024 主题演讲中,黄仁勋推出了Blackwell B200 张量核心芯片,这是该公司最强大的单芯片 GPU,拥有 2080 亿个晶体管,Nvidia 声称该芯片可以将 AI 推理运营成本(例如运行ChatGPT)和能耗比前辈H100降低多达 25 倍。该公司还推出了 GB200,这是一款“超级芯片”,结合了两个 B200 芯片和一个 Grace CPU,可提供更高的性能。

这一消息是 Nvidia 年度 GTC 会议的一部分,该会议将于本周在圣何塞会议中心举行。英伟达首席执行官黄仁勋周一下午发表了主题演讲。“我们需要更大的 GPU,”黄仁勋在主题演讲中说道。他说,Blackwell 平台将允许训练万亿参数的人工智能模型,这将使当今的生成式人工智能模型相比之下显得很初级。作为参考,OpenAI 于 2020 年推出的 GPT-3 包含 1750 亿个参数。参数数量是 AI 模型复杂性的粗略指标。

Nvidia 以David Harold Blackwell 的名字命名 Blackwell 架构,David Harold Blackwell 是一位专门研究博弈论和统计学的数学家,也是第一位入选美国国家科学院的黑人学者。该平台引入了六项加速计算技术,包括第二代Transformer Engine、第五代NVLink、RAS Engine、安全AI功能以及用于加速数据库查询的解压引擎。

Blackwell GPU 架构具有六项用于加速计算的变革性技术:

- 史上最强大的芯片——Blackwell 架构 GPU 包含 2080 亿个晶体管,然后通过高达10TB/秒的芯片到芯片链路连接成为一个GPU芯片;

- 全新的Blackwell架构还配备第二代Transformer引擎,支持双倍的计算和模型大小;

- 第五代 NVLink——为每个 GPU 提供了突破性的 1.8TB/s 双向吞吐量,确保多达576个GPU之间为最复杂的LLM提供无缝高速通信;

- RAS 引擎——Blackwell 支持的 GPU 包含一个专用引擎,可实现可靠性、可用性和可维护性;

- 安全人工智能——先进的机密计算功能可在不影响性能的情况下保护人工智能模型和客户数据,并支持新的本机接口加密协议,这对于医疗保健和金融服务等隐私敏感行业至关重要;

- 解压缩引擎——专用解压缩引擎支持最新格式,加速数据库查询,以提供数据分析和数据科学的最高性能。

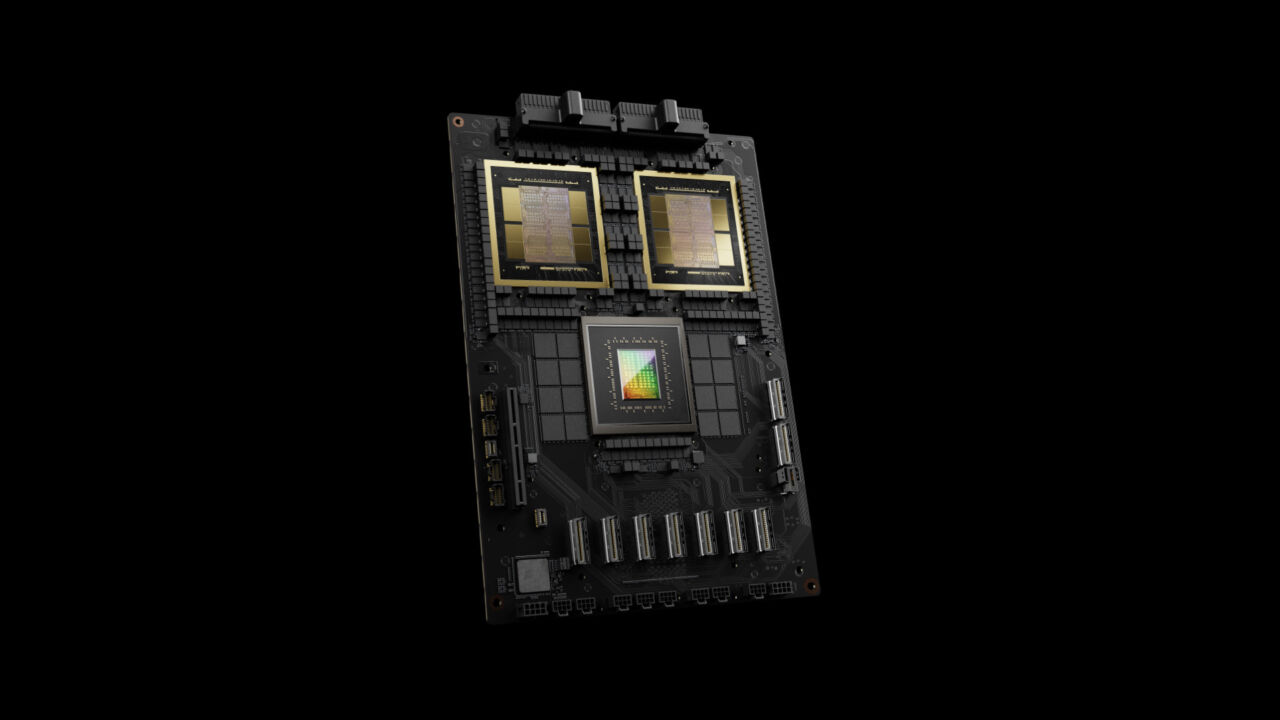

Grace Blackwell GB200 芯片将两个 B200 GPU 和一个 Grace CPU 组合到一个芯片中。

亚马逊网络服务、戴尔科技、谷歌、Meta、微软、OpenAI、甲骨文、特斯拉和 xAI 等几个主要组织预计将采用 Blackwell 平台,而 Nvidia 的新闻稿中充满了科技首席执行官的预设引言(关键马克·扎克伯格 (Mark Zuckerberg) 和萨姆·奥尔特曼 (Sam Altman) 等 Nvidia 客户对该平台表示赞赏。

GPU 曾经只为游戏加速而设计,现在特别适合人工智能任务,因为其大规模并行架构可以加速运行当今神经网络所需的大量矩阵乘法任务。随着 2010 年代新深度学习架构的出现,Nvidia 发现自己处于利用 AI 革命的理想位置,并开始设计专门用于加速 AI 模型的任务的 GPU。

Nvidia的架构(Architecture)进化历史:

- Blackwell

- Hopper

- Ada Lovelace

- Ampere

- Turing

- Volta:首款搭载 Tensor 核心 GPU

- Pascal

- Maxwell

- Kepler

- Fermi:The First Complete GPU Computing Architecture

英伟达对数据中心的关注使该公司变得非常富有和有价值,而这些新芯片延续了这一趋势。与数据中心收入(184 亿美元)相比,Nvidia 的游戏 GPU 收入(上季度为 29 亿美元)显得相形见绌,而且这种趋势没有停止的迹象。

野兽中的野兽

Nvidia GB200 NVL72 数据中心计算机系统

上述 Grace Blackwell GB200 芯片是新 NVIDIA GB200 NVL72 的关键部分,这是一款专为 AI 训练和推理任务而设计的多节点液冷数据中心计算机系统。它结合了 36 个 GB200(总共 72 个 B200 GPU 和 36 个 Grace CPU),通过第五代 NVLink 互连,将芯片连接在一起以倍增性能,训练算力几乎相当于一个超级计算机集群。

Nvidia GB200 NVL72 系统的规格表。

Nvidia 表示:“与相同数量的 NVIDIA H100 Tensor Core GPU 相比,GB200 NVL72 对于 LLM 推理工作负载的性能提升高达 30 倍,并将成本和能耗降低高达 25 倍。”

这种加速可能会在运行当今的人工智能模型时节省金钱和时间,但它也将允许构建更复杂的人工智能模型。众所周知,生成式人工智能模型(例如为Google Gemini和人工智能图像生成器提供支持的模型)非常需要计算。计算能力的短缺被广泛认为阻碍了人工智能领域的进步和研究,而对更多计算能力的追求导致 OpenAI 首席执行官 Sam Altman 等人试图促成交易以创建新的芯片代工厂。

虽然 Nvidia 对 Blackwell 平台功能的宣称很重要,但值得注意的是,随着组织开始自行实施和利用该平台,其实际性能和技术的采用仍有待观察。英特尔和AMD 等竞争对手也希望在 Nvidia 的人工智能市场中分得一杯羹。

Nvidia 表示,从今年晚些时候开始,各个合作伙伴将提供基于 Blackwell 的产品。

VIA https://arstechnica.com/i……

楼主残忍的关闭了评论