本文介绍在Windows使用ComfyUI本地部署Stable Video Diffusion,以图像或文本提示作为输入生成高质量的视频。

实践环境:

- Windows 11

- ComfyUI v0.2.4

- stable-video-diffusion-img2vid-xt

一、前期准备

1.安装 ComfyUI

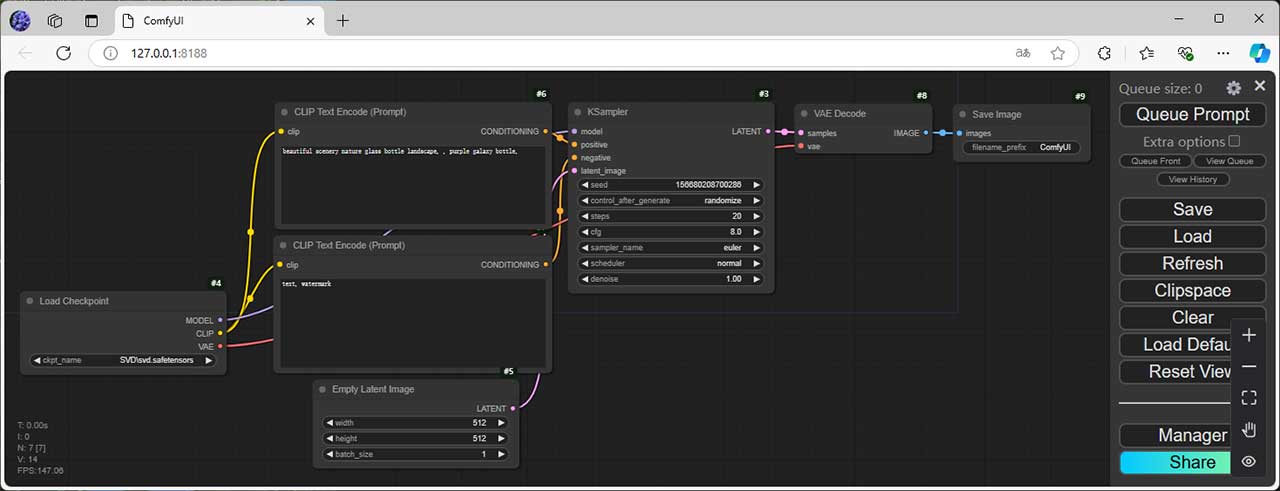

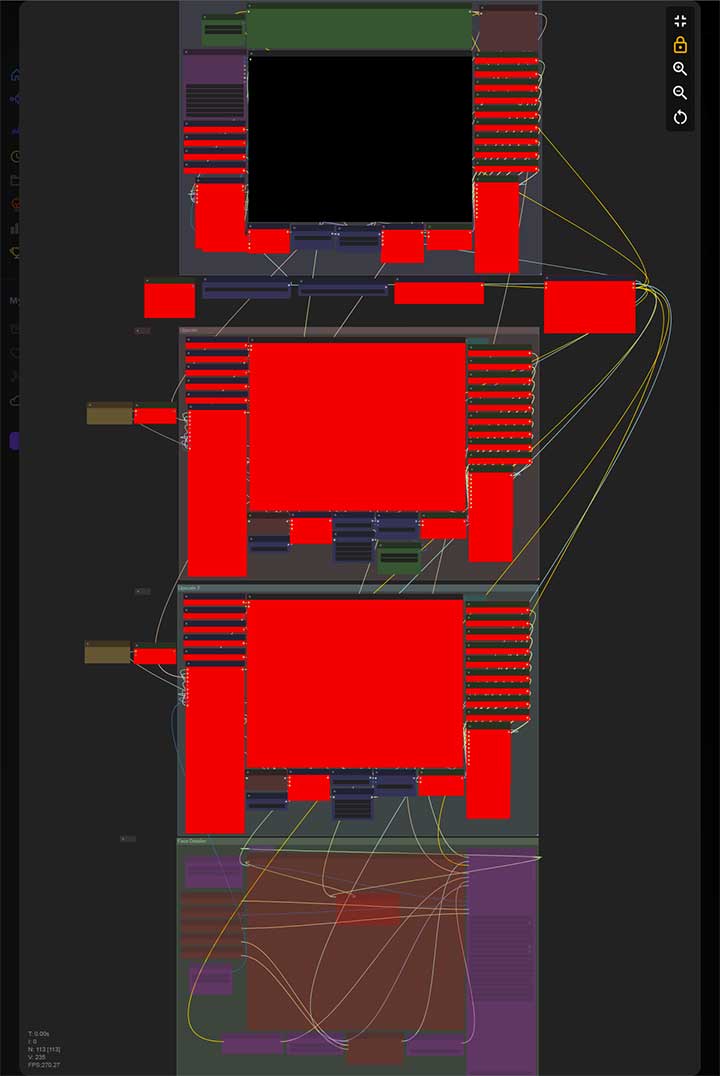

ComfyUI 是一个为 Stable Diffusion 专门设计的基于节点的图形用户界面,完全支持SD1.x、SD2.x、SDXL、Stable Video Diffusion、Stable Cascade、SD3、Stable Audio和Flux而无需编写任何代码,它使用户能够通过链接不同的节点来构建复杂的图像生成工作流程。每个节点都有自己独立的功能,如加载检查点模型、输入提示、指定采样器、生成图片等,通过输入和输出的线连在一起变成一个完整的工作流。相比易于学习和快速上手的WebUI,ComfyUI 提供了极高的自由度和灵活性。

节点式工作流广泛存在于各种生产力工具中,例如开源 3D 创作软件 Blender、实时 3D 创作软件 Unreal Engine、音视频制作软件 DaVinci等。

ComfyUI 安装成功后直接可以使用一系列基础的原生节点,它们为用户提供了广泛的功能和工具。用户还可以根据自己的需求开发自定义节点,以创建高度定制化的工作流,实际上社区成员已经贡献了许多个自定义节点,可以直接套用。

正好看到一个 Flux Dev 8 步肖像工作流,可以前往链接测试一下您对节点式工作流的喜欢程度

- Flux Dev De-Distilled Ultra Realistic + Detailed Portraits At Only 8 Steps Turbo

- rgthree-comfy——Making ComfyUI more comfortable!

- Exaflop Labs:Flux Watermark Removal Workflow

使用ComfyUI的核心在于理解节点逻辑。如果您希望更轻易地入门,建议使用SwarmUI,它是一款WebUI框架,默认使用了ComfyUI作为后端引擎,支持使用开源图像模型和视频模型。

在ComfyUI发布页面上有一个适用于 Windows 的便携式独立版本 ComfyUI_windows_portable_nvidia.7z(v0.2.4),可以在 Nvidia GPU 上运行,或者仅在您的 CPU 上运行。当您阅读至此时,ComfyUI Desktop 测试版已可供用户使用(ComfyUI Desktop User Guide)。

下载后直接解压即可。

运行run_cpu.bat或者run_nvidia_gpu.bat以启动ComfyUI,成功的话会弹出http://127.0.0.1:8188/浏览器窗口,并显示ComfyUI界面。

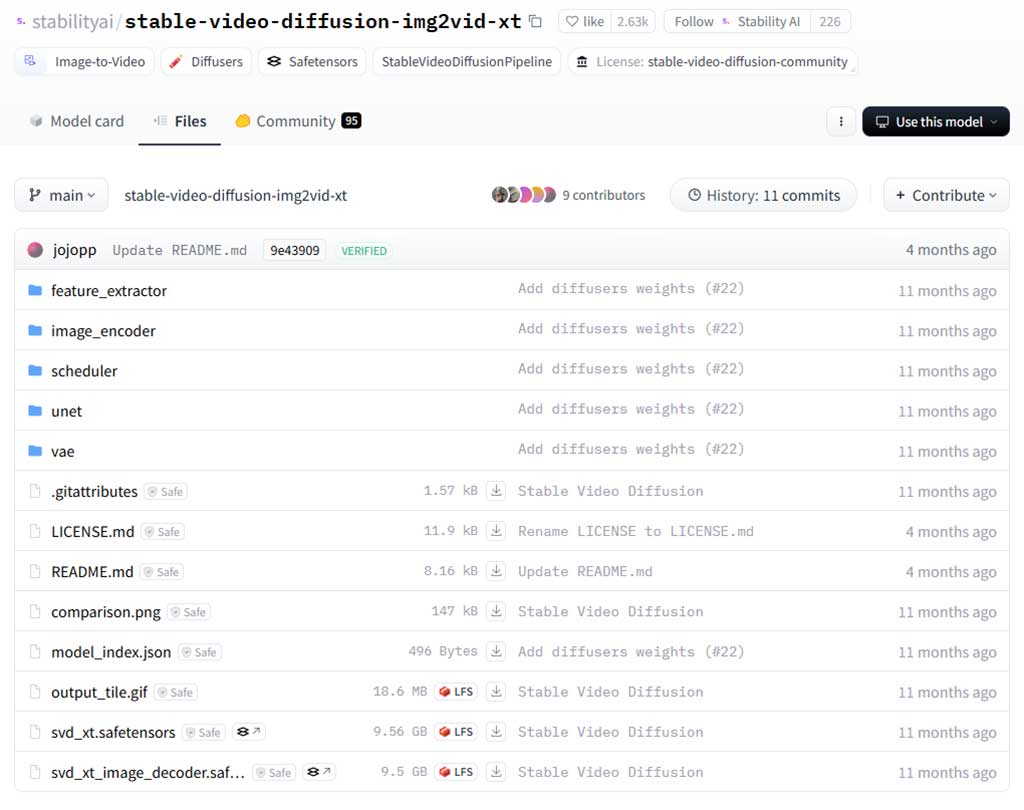

2.下载及安装Stable Video Diffusion模型和对应的插件

Stable Video Diffusion(SVD)是一种基于Stable Diffusion模型的视频生成模型,能够将文本和图像输入转化为生动的视频,以每秒 3 到 30 帧之间的可定制帧速生成 14 帧和 25 帧,因此有 14 帧的 SVD 或 25 帧的 SVD。

您可以直接下载Stable Video Diffusion模型,将它们放在 ComfyUI/models/checkpoints文件夹中(而不是ComfyUI\models\diffusion_models)。

也可以在ComfyUI界面中下载模型。

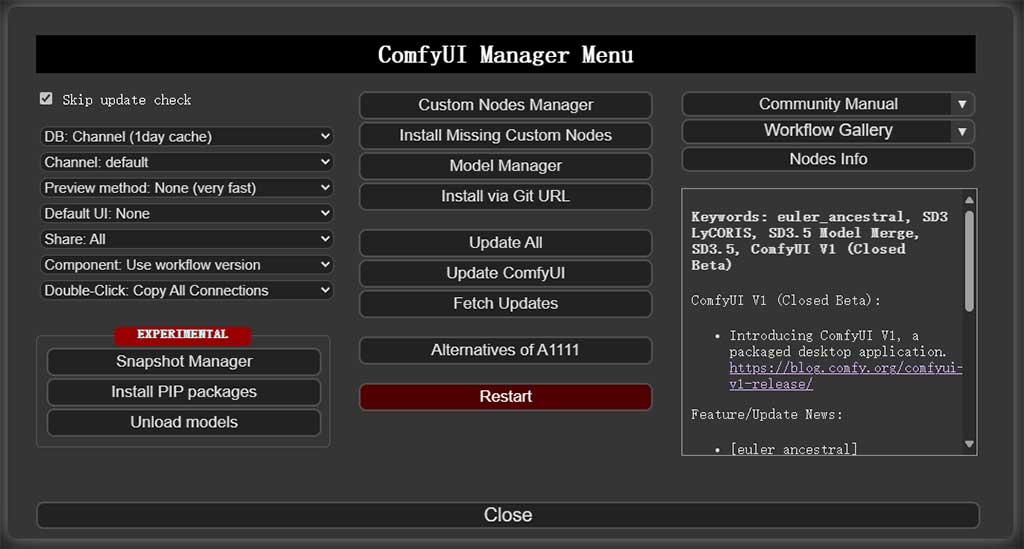

在ComfyUI界面点击Manager,选择Custom Nodes Manager,搜索svd,选择ComfyUI-SVD进行安装。安装完成后,点击重启按钮。

再次在ComfyUI界面点击Manager,选择Model Manager,搜索svd。根据您的显卡性能选择适合的模型版本,14 帧:Stable Video Diffusion Image-to-Video 或 25 帧:Stable Video Diffusion Image-to-Video (XT)。

二、使用Stable Video Diffusion

1.导入工作流

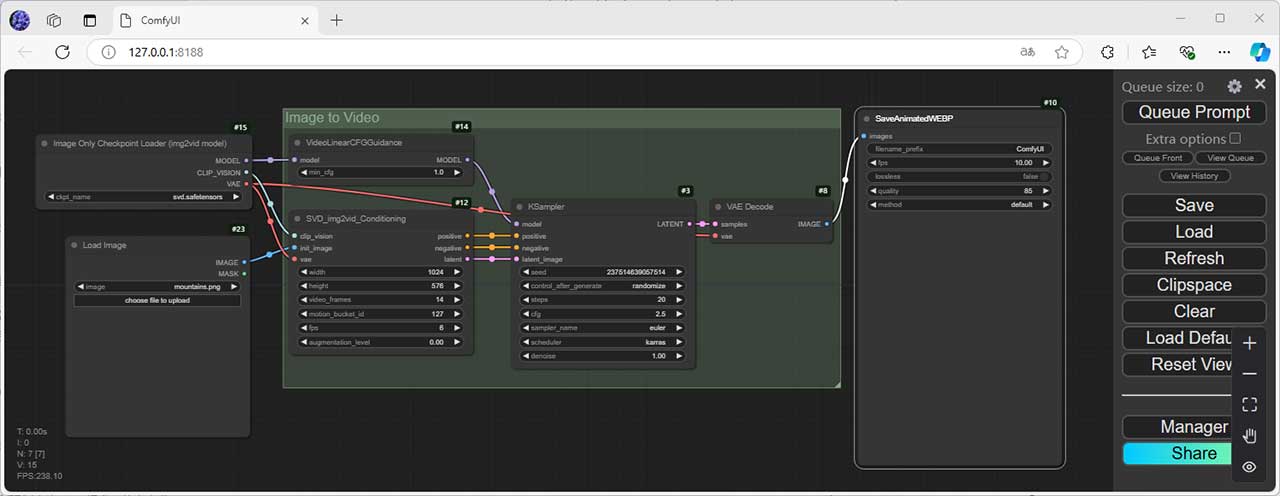

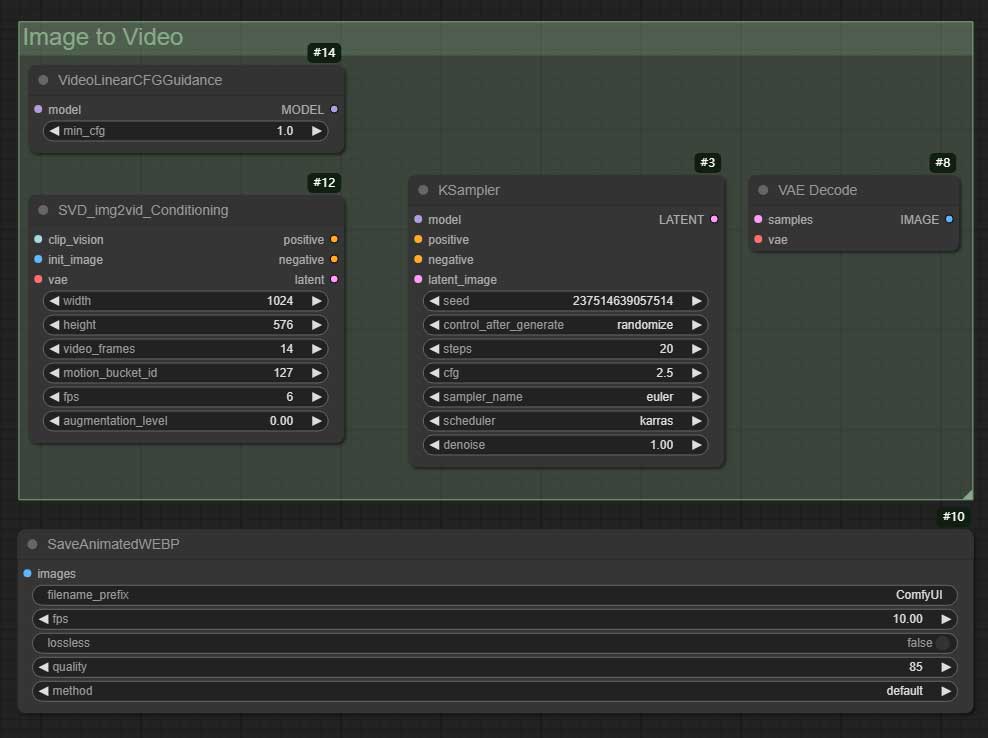

这里我们使用ComfyUI官方示例中提供的工作流(Json 格式),将Json文件拖入ComfyUI以获取工作流程。

2.上传图片

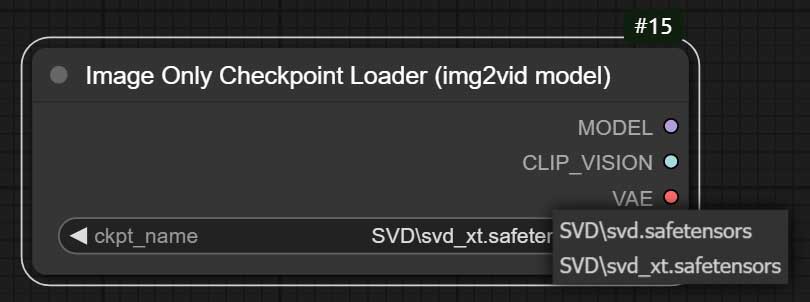

首先,在 ComfyUI 中的 Checkpoint Loader(模型加载器)中选择根据所需的帧数选择合适的模型。

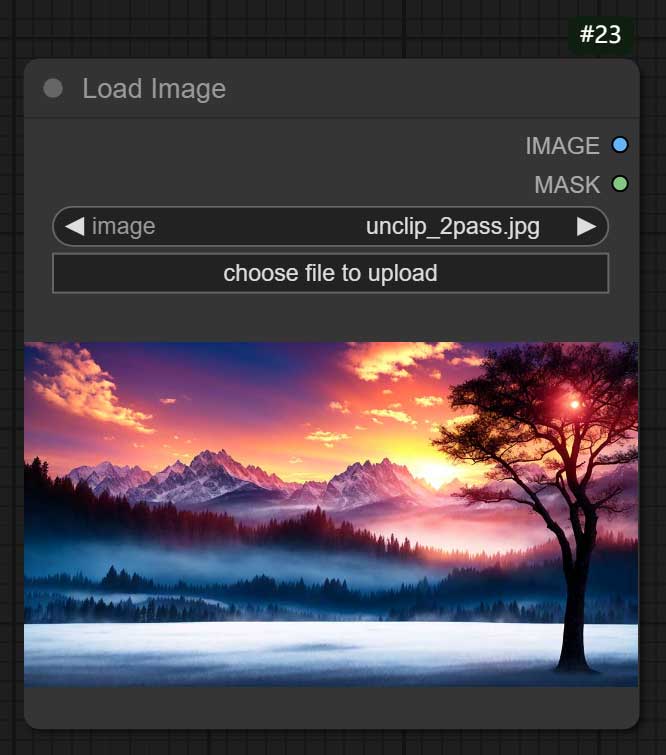

在 Load Image(图片加载器)中单击 choose file to upload(选择文件上传)要转换为视频的图像。确保图像分辨率对应自己下载的模型(默认值可能是1024 x 576)。如果更改分辨率,请记住也在工作流程中进行调整。

虽然SVD可以处理各种图像,但建议选择动作不太复杂的简单图像。具有清晰运动的图像(例如火箭起飞或火车沿轨道行驶)通常会产生更好的效果。尝试不同的图像类型,以揭示SVD的全部潜力。

3.调整参数

上传图像后,我们将会看到 video frames(视频帧数)、motion bucket(运动桶)、frames per Second(每秒帧数)和 augmentation level(增强级别)等选项。

- 视频帧数可以设置为 14 或 25,具体取决于选用的模型。

- 运动桶决定了视频中运动发生的速度。值越高,运动越快;值越低,运动越慢。

- 每秒帧数应保留默认值。

- 增强级别控制视频中的动画和细节级别。更高的增强级别会为背景和细节添加更多的运动和复杂性。

点击Queue Prompt执行,等待完成即可看到生成的视频,您可以在ComfyUI\output文件夹中找到,默认为webp格式。

参考指南

ComfyUI

ComfyUI + Stable Video Diffusion

👍

楼主残忍的关闭了评论